|

|

引言

. ?; q4 e. D1 m在人工智能领域快速发展的今天,生成式AI已成为热点话题。本文旨在帮助读者了解晶圆级AI技术如何推动生成推理的革新。我们将深入探讨Cerebras Systems公司的突破性技术,看它如何通过晶圆级引擎(Wafer-Scale Engine,WSE)实现超越GPU的惊人性能[1]。

( |6 J+ M+ v& e" c) W& J$ T6 O, l# H* m; Z3 i7 ^8 O' p

Cerebras晶圆级引擎

. c" I7 Y% m# `# `' O- g8 [Cerebras的核心创新在于其晶圆级引擎,这是迄今为止生产的最大芯片。, h. C: [/ y2 _7 `

zkb54uhwt0d6403229216.png

" C) P( @/ Z# j图1:Cerebras晶圆级引擎与传统GPU的尺寸对比,展示了其巨大规模。

8 Y: r! G8 I. m% `% i7 Q( i, }# p; I+ o7 u! \3 F. R# m

最新的WSE-3具有以下令人印象深刻的规格:

* C w1 C; _/ Y* I k6 S |2 I9 L$ q4万亿晶体管46,225平方毫米的硅面积900,000个AI核心125 Petaflops的AI计算能力44 GB片上内存21 PB/s内存带宽214 Pbit/s架构带宽采用台积电5nm工艺: `- F; E3 ]1 w1 J2 \% ?

. t! k; J. T0 O: S+ B$ q这些规格远超最先进的GPU。与NVIDIA的H100相比,WSE-3具备: R' J! `7 S" D

57倍的芯片面积52倍的核心数量880倍的片上内存7,000倍的内存带宽

5 \( X3 V) \4 N# P$ w# u" q3 K) O

) v. @8 y g6 Q. Z. R% w$ k- L( j: K/ V3 P4 G! V F1 C# D7 F

内存带宽优势# T8 a+ X1 l" s' E! ~- d

限制生成推理速度的一个关键因素是内存带宽。传统GPU架构在这方面面临瓶颈,因为生成令牌需要多次通过模型,每次都要从内存中读取所有参数。- m0 { ?4 T" D5 ]3 q/ ?2 E/ C

5 i Q8 d- e+ E% W% {

unfwfoirn3l6403229316.png

; g3 M' X+ `+ U' x( @, ^

; g3 M' X+ `+ U' x( @, ^

图2:Cerebras WSE-3与Nvidia H100的内存带宽对比,突显了巨大差异。1 ~" f/ z( K0 J- i% S1 |

/ T. _$ H0 }" v d8 b# ?- ]9 ?' z

Cerebras的晶圆级架构提供了巨大的内存带宽优势:

$ p0 T0 t3 V. a8 |% mWSE-3:21 PB/sH100:0.003 PB/s

1 P5 W( ?& Z3 n3 K5 p1 J% V

4 o/ A3 w3 w7 o$ |. P2 \; |1 b这7,000倍的内存带宽增加对生成推理性能产生了革命性影响。

% i- s5 h b# P6 c: }* u6 G# T2 Q$ W4 H# f! w3 p; I

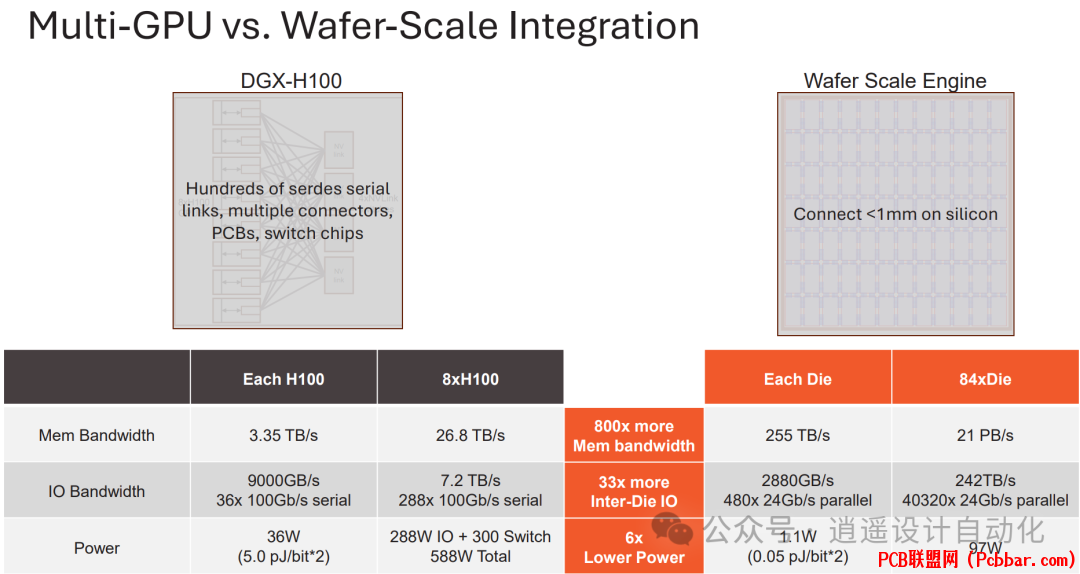

晶圆级集成vs多GPU解决方案虽然多GPU解决方案试图通过在单个服务器中集成多个GPU来聚合内存带宽,但这种方法存在显著缺点:, v3 j! x9 b( h

* n X& E' a( C l6 s9 B

ueauuoctfhh6403229416.png

- H6 |2 c; J. g3 Z* P% ?* V

- H6 |2 c; J. g3 Z* P% ?* V

图3:多GPU和晶圆级集成的对比,展示了内存带宽、IO带宽和功耗的差异。" a" _& _) m. |1 C1 m: U1 q# w: y

/ V5 ?% V- f- |' h! }

晶圆级方法提供:

1 h- ~, n6 b4 q7 ?800倍的内存带宽33倍的跨芯片IO6倍低的功耗8 w) R6 A9 D4 @7 x: w* k

. K: |, O6 o& K" ?, [. H5 l此外,多GPU解决方案由于互连带宽和延迟开销而存在扩展效率问题。随着GPU数量的增加,内存带宽利用率显著下降。

' N4 q1 c+ v0 F7 ~$ n4 g" r

D4 S3 u3 A5 U( N, l

puwxlghwcac6403229517.png

% v8 d4 [0 L0 _6 Z

% v8 d4 [0 L0 _6 Z

图4:图表显示了在DGX系统中增加GPU数量时内存带宽利用率的下降。6 x' I7 T- Z# B- ~% n4 A% @: A

8 {. W; ~3 U) j# o

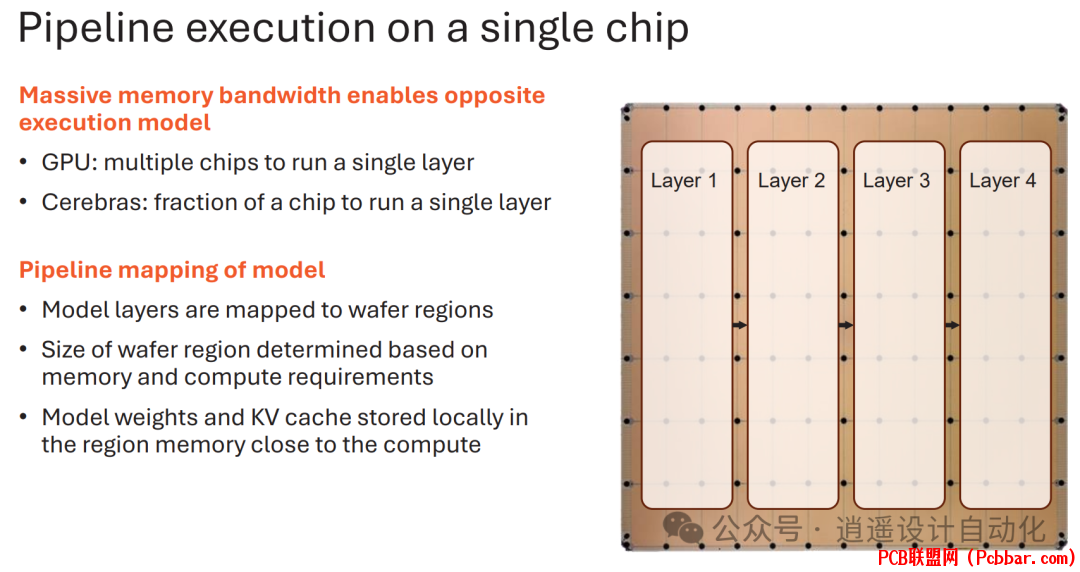

单芯片上的流水线执行) W/ v2 K; `9 l* o" V

Cerebras的巨大内存带宽实现了独特的执行模型:

" d0 Q3 t! l# }7 q- ]) Y, ~& A

p0d3zkjhjxk6403229617.png

' ~+ u; F# p* X3 c9 ~4 m, z

' ~+ u; F# p* X3 c9 ~4 m, z

图5:晶圆级引擎上流水线执行的图示,展示了模型的不同层如何映射到芯片的各个区域。

% z0 X: c: Y- [- i

# Y8 T( ?5 T9 d在这个模型中:模型层被映射到特定的晶圆区域权重和KV缓存存储在区域内存中每个晶圆区域一次处理一个令牌相邻区域实现流水线阶段之间的低延迟通信

, l9 J& C/ C! ]0 m$ w: L- \5 Z[/ol]( g9 b. X+ C2 l7 i8 B; z3 ^

这种方法允许极快的令牌生成,因为整个过程发生在单个芯片上,阶段之间的延迟最小。8 u( w. ]% X N( x4 v

/ [% E" t$ j* C0 ?9 Z& V

& g$ Y. J; z' H% s4 Q大型模型的可扩展性

7 O7 }, g9 F4 R! R+ F' \对于超出单个WSE容量的模型,Cerebras提供了可扩展解决方案:

' @3 a5 ?! @+ ], r! s( m

g53nkapi2bs6403229717.png

1 S* G% ~/ \0 _2 W- k4 G8 |; v" [图6:图表展示了如何将较大的模型映射到多个晶圆级引擎上。

1 i- Y7 P6 w0 k3 h P! I

! s) N/ X4 o/ k( p% \# \* X通过将模型层分布在多个WSE上,Cerebras可以容纳最大的语言模型,同时保持高性能。晶圆间通信经过优化,以最小化延迟和带宽需求。8 T. q1 n/ I( }1 F

E* S# G1 }4 i, G, G

高吞吐量和低延迟

- j! K2 F, M* L* i& ~与GPU面临延迟和吞吐量之间的权衡不同,Cerebras的架构能够同时实现高单用户速度和高多用户吞吐量:1 g7 q9 v; E' t. N

2 R2 h+ T* R* t9 Q$ y$ S

bjdhrdmhb1j6403229817.png

* L. }# j2 f4 o8 t0 F7 R P图7:GPU和Cerebras系统的延迟vs吞吐量权衡对比图,显示了Cerebras在这两个指标上的卓越性能。# j! }7 e0 {3 T0 i% F4 a" \0 K

8 L ], }0 h! A2 KWSE可以同时支持多个用户,每个用户并行访问模型,而不会牺牲个人性能。这得益于晶圆上可用的大量内存带宽。# ~- y1 {& J& Q: v3 P9 w- L1 I

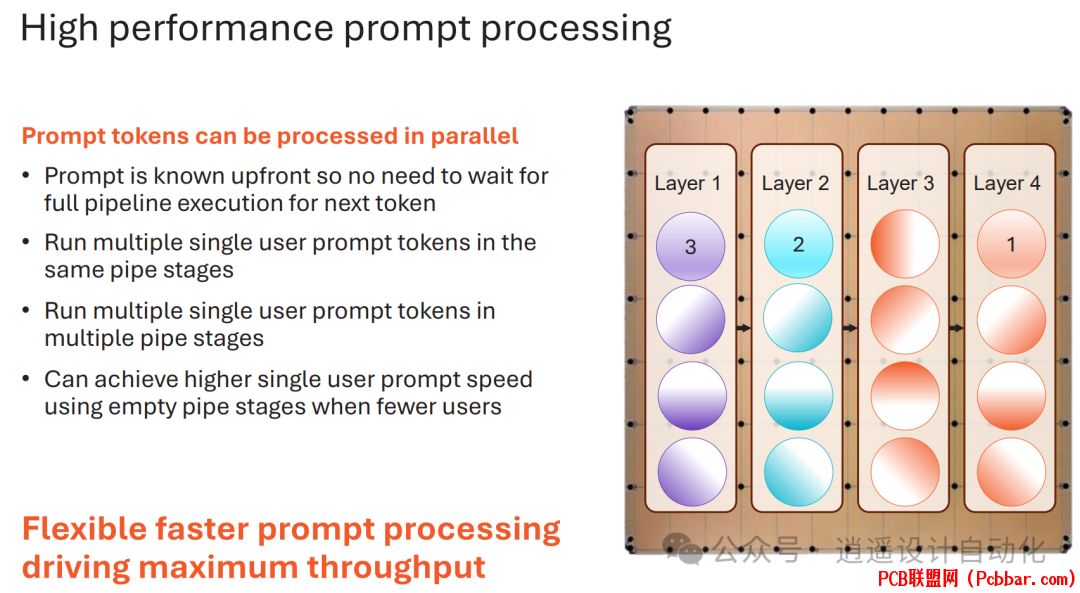

" t* W6 y, @7 N提示处理优化

; O$ {2 }0 z: _* CCerebras通过高效的提示处理进一步优化性能:" W Z- X! b$ N& h2 u8 C7 D- u" {: ~

o2lfgd0c0s06403229918.png

$ S* Q8 y7 l/ \7 Q图8:图示展示了Cerebras如何通过同时利用多个流水线阶段来优化提示处理。% E- q( ~( p' ^$ N* m0 j/ u& `

% c* O; m. `& o- K% d

通过在不同流水线阶段并行处理多个提示令牌,Cerebras实现了更高的单用户提示速度并最大化吞吐量。

0 A/ _! ]3 L- ^- h6 w

5 g' E O1 e- R% _7 [ ^! G未来改进5 c J5 Y o8 ]1 \, W$ F' s+ e

Cerebras正在持续研究技术以改善性能并支持更大的模型:

- r& l5 X5 E; l推测性解码KV缓存优化量化稀疏性更多即将到来的技术

. W$ a0 h0 k3 s/ j, k

" \8 A# P- u; W这些改进有望进一步推动AI性能的边界。' ?* [* f; F# H" R0 C

/ {& [. Z+ Y% e9 x( ]

9 `' O0 \$ l& x, M% }& @, P# }Cerebras推理服务* ~+ P) e8 Y7 i$ P. G1 K! G+ ]

为使这一突破性技术更易获取,Cerebras推出了推理服务:7 Q+ I: I% a3 `( Y/ e5 w

oy5hig40yq36403230018.png

" }. Z3 i6 \$ O( K) ]$ A

" }. Z3 i6 \$ O( K) ]$ A

图9:Cerebras推理服务界面的截图,显示可用模型和定价层级。1 }& K3 [2 K1 i- A% I* _; k

+ v* g# a( G2 O+ o& L4 h

该服务提供:

& N c( l& O, ?) H( D: b2 jLlama3.1-8B,速度为1,800令牌/秒Llama3.1-70B,速度为450令牌/秒免费层每分钟30个请求,每日100万令牌限制付费层提供有竞争力的定价4 O6 o, R5 K+ x6 s

0 }9 o; }# k9 c" b: Y# R未来服务将增加更大的模型,如Llama-405B、Mistral Large 2、Cohere Command R,以及定制微调模型。% A; k" I3 L: B$ U/ Q

8 T: h5 Q9 ]$ ^/ `6 L0 p结论

6 W8 o2 [1 I# ^8 O4 ]4 T ]! TCerebras的晶圆级引擎技术代表了AI硬件的范式转变,为生成推理提供了前所未有的性能。通过解决内存带宽瓶颈并在大规模上实现高效的流水线执行,Cerebras正在为AI应用开启新的可能性。随着技术的不断发展,我们可以期待AI性能的进一步提升,为各行各业的更复杂和响应更快的AI系统奠定基础。' r! y( K/ p7 b0 a; l: D# t& G

/ v8 a5 T7 z+ p$ c, X

参考文献7 D( K% p T6 |! p

[1] S. Lie, "Wafer-Scale AI: GPU Impossible Performance," in Hot Chips 2024, 2024.5 O. ~2 K6 m0 c4 N

/ Z4 r; \0 B- v7 k

- END -

% ~6 i6 n' X) X% v, n6 U3 K$ [9 C- F n( j: f6 W# b4 p7 b- v

) m u( \2 ?4 h9 r0 K软件申请我们欢迎化合物/硅基光电子芯片的研究人员和工程师申请体验免费版PIC Studio软件。无论是研究还是商业应用,PIC Studio都可提升您的工作效能。+ Q! u8 W( F2 F5 L1 _

点击左下角"阅读原文"马上申请

( i* ]* l, E6 d1 @% w2 J' E1 Y3 {% t( P8 q6 P$ |# i$ P" |( T) ]

欢迎转载6 q; Y4 J& F+ m" E

" N& @0 ^0 A2 V% q$ I& ]5 v转载请注明出处,请勿修改内容和删除作者信息!; U! i! r# t. [- b& _0 V# g* m

( z a ^0 p) ~8 }: M! @: r' O

7 \% i9 x0 M: j. i2 V( Z+ c

" ?4 `( H+ x) {/ f& A+ F3 E" \

xdsmq4ljvvw6403230118.gif

9 {4 X W4 i, |8 Y' F7 @9 Q' u, X7 I

9 {4 X W4 i, |8 Y' F7 @9 Q' u, X7 I

. @2 m! W* H, _! H# D$ Z! r+ }

关注我们

/ [ g3 y7 m8 z1 z' D

& G4 r) z6 }. B$ ]7 u% u3 M% ?! K+ B4 K8 r" N

ageyh1452lr6403230218.png

, z2 O5 c n7 c) l& D& G

, z2 O5 c n7 c) l& D& G

| 8 N! N- j6 }5 \& d

34vohyi4mvw6403230318.png

% R9 M, Z3 l( F5 |' o& z | ) O0 _; B1 {7 K$ d# u

0tpz35msta16403230418.png

" W- t0 o. W1 X C9 x8 m5 n, ~ |

$ o' `3 x6 x% u1 E5 x

4 \. k4 L, O0 t/ |- q& c- |/ E) k4 A1 J9 x3 y1 \6 |6 p. h

( x( U7 k/ b# U+ |. @1 F7 ^, g5 Q% t

关于我们:6 G6 K) ]) f5 {8 A+ `

深圳逍遥科技有限公司(Latitude Design Automation Inc.)是一家专注于半导体芯片设计自动化(EDA)的高科技软件公司。我们自主开发特色工艺芯片设计和仿真软件,提供成熟的设计解决方案如PIC Studio、MEMS Studio和Meta Studio,分别针对光电芯片、微机电系统、超透镜的设计与仿真。我们提供特色工艺的半导体芯片集成电路版图、IP和PDK工程服务,广泛服务于光通讯、光计算、光量子通信和微纳光子器件领域的头部客户。逍遥科技与国内外晶圆代工厂及硅光/MEMS中试线合作,推动特色工艺半导体产业链发展,致力于为客户提供前沿技术与服务。

1 K$ s& P7 m2 Z

7 f$ a. y5 k' o: z C. r4 {http://www.latitudeda.com/

( D7 H2 `4 R6 L% G$ ~(点击上方名片关注我们,发现更多精彩内容) |

|