引言

9 K7 d$ |( d& f* f3 b. Z人工智能技术的快速发展为众多领域带来了前所未有的进步,但这种进步伴随着大量的能源需求。生成式人工智能革新了高级机器学习模型的可及性,将强大的人工智能能力直接交到普通用户手中。生成文本、图像、视频和音频的工具使人工智能更加民主化,推动了各行业的创造力、生产力和创新。/ Z$ ]% w8 C( [0 ^+ ^

2uwpzd41dvk6401028754.png

. Z7 ]3 |8 E8 \1 L% R( I

. Z7 ]3 |8 E8 \1 L% R( I

$ z) _9 e6 P9 b5 B$ f" k

然而,这种广泛的可及性带来了显著的代价,特别是在训练和部署这些庞大模型所需的能源方面。像GPT、DALL-E和其他多模态人工智能系统等大型生成模型需要大量计算资源,这转化为在漫长的训练过程和实际部署中的高能耗。5 h* ^9 f# y) F2 ?! `- D

5 h3 I" Y) i9 I( |4 Z1 \

虽然人工智能系统变得更加先进和强大,但快速增长带来了资源需求方面的重大挑战。训练大型人工智能模型的计算需求极其巨大,通常需要专用硬件如GPU或TPU长时间运行。这导致能源消耗增加和相当大的碳足迹。例如,训练单个2.18亿参数的语言模型可能产生与多辆汽车整个寿命周期产生的排放量相当的排放。由于复杂度差异,ChatGPT查询使用的电力是Google搜索的10倍以上。

# D; X' `3 U; R! q9 W- [+ N, {: f1 H I

分析师估计,由于人工智能需求增加,到2030年,计算机服务器可能使用世界电力的10%或更多,高于今天的2%。人工智能模型的能源消耗已成为一个紧迫问题,威胁着该领域的可持续发展[1]。

) f$ ?5 l, N# b" [6 C* {

u4e0lnltok06401028854.png

* |1 |& X* `/ m- B& t: V图1展示了美国数据中心能源消耗的增长趋势,强调了数据中心占美国总电力需求的份额到2030年将显著增长。

4 r' P, f" t& {+ o7 p; g2 V; w) d; J

bjqgve1syir6401028954.png

, p6 a/ x, x) u6 J: ]# S

, p6 a/ x, x) u6 J: ]# S

图2说明了过去二十年中训练人工智能模型的能源消耗和碳排放急剧增加,展示了人工智能对环境影响的指数增长。) G" Z9 i+ @5 E2 ~' G6 w& T# T

! ~* O& ~6 I, ?1 g

y4l0uw3dpdt6401029054.png

* t/ t: N, M. d3 b) ~2 b5 l* d* o p

* t/ t: N, M. d3 b) ~2 b5 l* d* o p

图3展示了未来几年人工智能电力需求增长的预测,展示了预期的陡峭上升轨迹。! y# W& h$ y8 |6 ~, ]# g( D

& j) ~9 X7 T8 n! h) V2 T) P8 ?

zb5wmokjkjr6401029154.png

! D4 j8 o# W4 S% {- o图4显示了训练脑规模人工智能系统的预测能源需求,并识别了限制效率的三个关键内存瓶颈:内存墙、更新墙和整合墙。# M' }% G' `9 r. \5 y3 ^

, @* k/ c' R$ ]& h: y

人工智能的未来承诺在各个领域带来非凡的进步,有潜力革新从医疗保健到自主系统的一切。然而,要充分实现这种潜力,我们需要解决三个关键挑战:使人工智能显著提高能效,克服当今人工智能系统的局限性,以及开发支持物理智能的创新模型。

- w" O) g% ^3 Y) S' U9 B' k0 z& E ^8 t ?) a

1. e* ~" [7 N, Q: E$ U

高能效人工智能6 p9 |& B g# M

人工智能主要通过两个主要阶段消耗能源:训练和推理。训练是指通过向模型提供大量数据集并调整其内部参数来教授模型的过程,需要大量计算资源。这个阶段能源密集,因为需要使用高功率GPU或专用人工智能硬件在大型数据中心中重复处理和分析大量数据。

' |. k( v1 W/ c. h' D y0 g1 X& G m1 l/ i- i- s+ m- o

推理是指训练好的人工智能模型根据新输入数据进行预测或生成输出的阶段。这是当用户与人工智能系统交互时发生的计算,例如查询聊天机器人或使用推荐引擎。随着人工智能模型扩展并部署到数百万用户,推理逐渐成为能源消耗的重要贡献者。

' f' C4 X" `4 H/ W

7 l' }. s. L \" z随着模型变得更大更复杂,需要更多的层、参数和计算,能源成本急剧上升。更大的模型需要更多的计算资源,训练和推理在电力、冷却和硬件需求方面变得越来越昂贵。

/ ?; j3 h1 k# L( n' |% K4 V" N1 D7 V1 j; s7 h) t

为解决人工智能能源挑战,高效硬件在减少人工智能系统能源消耗方面发挥关键作用。专用硬件,如Google的张量处理单元(TPU)和边缘人工智能芯片,专为处理人工智能工作负载的计算强度而设计,与通用处理器如CPU或GPU相比消耗明显更少的能源。TPU针对深度学习模型中基础的张量操作进行了优化,可实现更快的计算并消耗更少电力。

1 T: [; W# a: t- U) Q4 i+ \4 O* c, s' p$ t/ j' T& L4 m# C4 {9 E

研究表明,通过设计特殊芯片,人工智能模型可以仅用一小部分计算能力运行,同时仍能提供卓越的结果。这些芯片可以消耗不到三分之一瓦的功率,比通用移动处理器能效高10倍。关键见解是通过分配任务的专用电路,最小化核心需要与远距离内存库交换数据的频率。' e( ~2 W. e ?, G' |; ~) n. X

2wzvtezb4en6401029254.png

% b2 X% F# k. z& N0 m6 R图5展示了核心重新分配间隔为5微秒的Shenango运行时与1毫秒核心分配器模拟相比,达到了更高的CPU效率,体现了细粒度资源管理的重要性。

) @. x6 y/ a' J0 `3 L, X6 r' t+ s

0 U6 E, \, @( {4 V2 P) U模型压缩是减少训练和部署大型人工智能模型相关计算和能源成本的重要方法。剪枝、量化和知识蒸馏等技术旨在减少神经网络参数,同时保持模型性能。剪枝涉及识别并移除模型中冗余或不太重要的权重或神经元,形成更高效的结构,同时不会大幅影响准确性。/ V" \3 X- U4 a/ B- c" |% S7 Z' ?# r

5k1zau4ec136401029355.png

/ w0 f) K* B$ C8 F* Y% |, |. F

/ w0 f) K* B$ C8 F* Y% |, |. F

图6显示了对三个流行数据集(MNIST、CIFAR和FashionMNIST)进行压缩后的相对误差评估,网络架构各不相同,展示了压缩如何影响性能。* U; r3 u5 w D! J3 `/ t7 t* D

1 k3 d* `0 C& \

zsrto0fazau6401029455.png

9 {; v6 H* B' U$ b% q+ C/ b( r0 N

9 {; v6 H* B' U$ b% q+ C/ b( r0 N

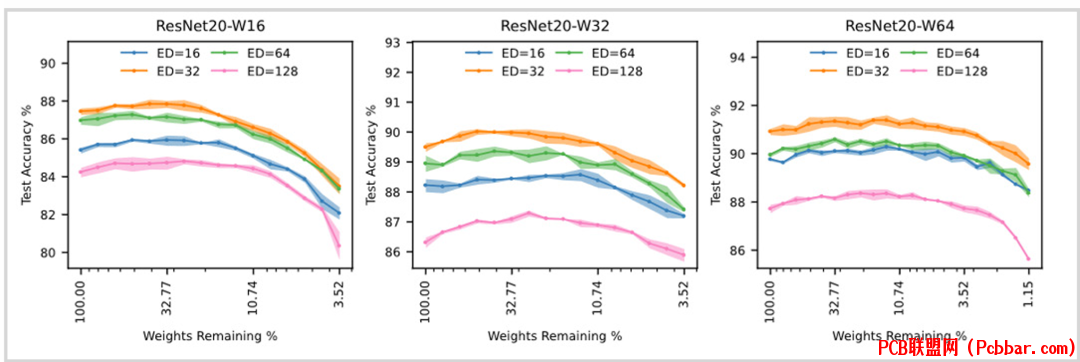

图7说明了随着保留的模型权重变化,测试准确率如何变化,揭示了模型可以显著剪枝同时保持合理性能。+ M. e8 g. x( u, M" H

2 n- K& n9 t, F, z( y6 J ?

vgt41dufkqt6401029555.png

7 I$ s- E/ C9 C/ ^! E9 \图8显示了在NVIDIA V100 GPU上深度神经网络训练的归一化能源使用情况,突出了通过优化技术可以实现的能源节省。

, D' d" Z {4 V8 w

- d, }: ~* r3 U! W, V6 d+ ]算法优化通过减少模型训练和推理所需的计算资源,在提高人工智能系统能效方面发挥关键作用。一种关键方法是开发高效训练算法,如稀疏变换器和状态空间模型。稀疏化模型通过仅关注输入中最相关部分来优化数据处理,显著减少操作数量。0 v' K8 V2 h* [1 }

4 E- f Z# T; U9 ~; F9 W j7 t2

8 \" t. ?$ R2 n1 C2 u" u人工智能状态空间模型. `( x' n# Q" S

状态空间模型(SSM)正在成为人工智能的新技术。SSM设计用于处理序列数据,使用基于物理的技术捕获时间和空间依赖性。与控制理论中的传统状态空间模型不同,这些机器学习模型专注于从数据序列中学习底层表示。例子包括高级模型如液态网络、振荡网络以及像S4(用于序列建模的结构化状态空间)和Mamba等状态空间模型。

) G9 B. q0 D' b2 z" p

! h- u% v1 ]6 {这些新模型设计擅长处理长序列任务,提供内存高效的方式处理大量数据流。例如,S4和Liquid S4使用结构化状态空间矩阵处理时间序列和序列数据中的长程依赖性,比传统的循环神经网络(RNN)或变换器更高效。4 u. X9 L& w2 V# y+ p

6 B( t% e5 ?. L8 S# n液态网络模型是一种状态空间模型,可以实时动态适应输入数据,允许网络结构随着新信息处理而演变。液态网络受水库计算和神经动力学原理启发,在这些原理中,内部神经状态是流动的,可以随着新刺激的出现而改变。

6 l+ i7 v/ v# X1 ^$ A

tk5mpl0nn3n6401029655.png

+ u( S6 M6 c2 e5 ~* W图9对比了经典人工神经元(左)与液态神经元计算(右),展示了计算方法的根本差异。

0 X# q. [0 \8 X! a& Z D& B1 ]. c* V, t

液态网络的核心是其独特能力,可以响应输入数据模式自适应连接和内部状态表示。与推理期间保持固定权重的传统神经网络不同,液态网络持续更新参数,使其能够处理更加动态、不确定或可变的环境。) [, ^9 A) U( x- q

: z O* Q3 U3 V6 q

液态网络还旨在克服机器学习相关的几个技术问题,其中之一是缺乏可解释性。液态网络提供了简化神经网络架构的方法,使用户能够了解模型的决策过程。由于神经元的计算和架构,液态网络更容易查看内部运作。 w5 D+ r4 Q4 F5 G1 Q; r7 M

rsi10v0up4p6401029755.png

# |: l# l) ?& k: a1 x! W

# |: l# l) ?& k: a1 x! W

图10比较了不同参数数量的液态基础模型与其他基础模型在MMLU-Pro基准测试上的性能,显示了LFM的最先进性能。5 m3 a4 ^% e: I' Z9 o: A

3 O" w! a+ e) c# g; ?

kmfo0azgxlh6401029855.png

9 S% Y8 u( p6 u4 X- u# N8 O5 P" l图11说明了液态基础模型与其他语言模型相比的显著内存效率优势,特别是随着序列长度增加。" C- G$ o7 F. `4 [1 Z

4 [5 H, M& ^+ _! n& [液态网络已被证明对时间序列和序列数据任务非常有效,包括视频分析、传感器数据处理、金融交易和自然语言文本处理等应用。根据时间模式动态调整内部状态的能力使液态网络特别适合数据输入序列重要的实时应用。

Z5 X1 T: f0 C. e" w( F2 U6 F; l% s: h; g: H8 x; r" q

LFM(液态基础模型)与基于变换器的架构相比,特别是在处理长序列时,内存占用显著减少。这一点很重要,因为在变换器中,键值(KV)缓存随着输入长度线性扩展,导致大量内存消耗。相比之下,LFM可以高效压缩输入数据,使处理更长序列不会出现相同的指数内存增长。% b2 g9 d: a1 c# G

7 ?8 H* a* e1 ~* U! @ A

3" `8 {+ w! @" c# \. V* g

物理人工智能

. U) k0 m, L) d随着生成式人工智能系统持续迅速普及,这些系统大多局限于数字世界,而非我们实际生活的物理世界。物理世界具有物理定律和不精确性,对于最复杂的人工智能算法也是极具挑战性的。随着我们对人工智能的期望超越数字边界,开发和使用不仅能模拟而且能深入理解物理世界基本原理的基于物理的模型(如状态空间模型)变得非常必要。

) j, q9 ]% o" H- p6 q; k( I

' W9 u( W6 Q" y5 P4 L( B6 D, s目前,大型人工智能模型主要在基于云的基础设施上运行,这提供了必要的计算能力,但代价是显著的能源成本和碳足迹。然而,对于许多实时应用,如机器人和基于传感器的系统,依赖云计算因需要即时响应和持续数据传输的挑战而不切实际。

7 H j* E* }% c$ C# J

/ t! f5 V+ T7 p物理智能或物理人工智能,是指将人工智能理解数字文本、图像和其他在线信息的能力用于使现实世界机器更智能。物理智能需要紧凑的模型,这些模型理解物理世界,无缝集成在机器内部,能够精确无误地运行。基于变换器的模型无法做到这一点,因为这些模型经常产生幻觉,无法可靠捕捉世界物理规律,且需要不适合消费设备的服务器农场。3 L! G F* e5 E" E

0 G$ a3 z- p! x. k1 d u4 b同时处理文本和传感器信号的能力使我们能够将感知、语言和行动作为智能的基础。语言为智能机器提供了更高层次的抽象和推理。在机器人技术中,物理智能通过提供感知、行动和语言的整合使自动驾驶汽车等机器人变得智能,使机器人能够在越来越符号化的层次上解释和与环境互动。

+ x9 z' p, T: s9 A1 |1 M

4 P+ S0 C8 k7 r3 i1 I随着人工智能不断突破可能性边界,能源效率正成为确保这些系统可持续性的关键因素,特别是当这些系统超越数字领域进入现实世界物理应用时。状态空间模型和液态基础模型等创新显示出解决这一挑战的巨大潜力。通过提供高效内存利用和精简处理,这些模型特别适用于能源消耗是主要考虑因素的应用,如移动设备、机器人和边缘系统。# d8 S! e1 q8 N0 Y

M$ v4 O! D% Q* w4 \7 v

如果2023年是文本到图像的年份,2024年是文本到视频的年份,那么2025年可能标志着物理智能时代的到来,包括文本到行动、文本到任务、文本到设备和行动到环境。这一变革时期将见证物理智能集成到广泛的物理系统中——从机器人和传感器到电网和智能家居——使这些系统能够解释并执行由文本、图像和行动派生的复杂命令,从而连接数字指令和现实世界执行之间的鸿沟。+ g3 \. `4 {& L. l3 G) {" k: b

' x$ V$ v3 h/ S3 a0 M4 b* Q9 a

参考文献9 a. [* [- c! r2 g8 F! r. \

[1] D. Rus, "From Chips to Thoughts: Building Physical Intelligence into Robotic Systems," in 2025 IEEE International Solid-State Circuits Conference (ISSCC), Feb. 2025; k- x+ j. @2 x" y" _

END: o6 D5 Y0 a1 D9 j5 `- w

! y' X: C& _+ K: v

软件申请我们欢迎化合物/硅基光电子芯片的研究人员和工程师申请体验免费版PIC Studio软件。无论是研究还是商业应用,PIC Studio都可提升您的工作效能。

" [& E. k$ z& m% S. H2 ^点击左下角"阅读原文"马上申请3 J( M/ q8 X k. Y5 ~) w2 ?

. V3 b% |, n& [" T' w/ H P欢迎转载

# N& L: T2 y" c8 K/ h8 v

" W" k0 D9 M# \1 ^8 p. `转载请注明出处,请勿修改内容和删除作者信息!

* P( s$ V4 u2 K- U/ G7 F

+ K) |% l9 ^5 y6 y: f A5 |' C9 t$ C

2 d8 W& x/ i0 M5 ~* l: k- X r4 f+ V* x

v4ms32whtnb6401029955.gif

8 ^: p. V% `; X5 l% k

' A9 }, U+ i4 G. Y3 T0 |' g3 t关注我们

4 J+ v% B- O( Q4 s5 c# Q% R! R: o

" x4 k+ E2 q) |+ O1 ?( M

xwqqkiitgri6401030055.png

& E& C& p: F' }6 L6 ^8 f$ ]. B

& E& C& p: F' }6 L6 ^8 f$ ]. B

|

! v$ M. v1 z4 R; \+ x" h

4hwtpkckern6401030155.png

0 o7 K; S: z" h" J6 v. ]

0 o7 K; S: z" h" J6 v. ]

| j; S1 e% O' H6 {9 ~

gx4lpdqfhgu6401030255.png

. o9 P+ l* |# `- R3 |; C0 T ?* j |

" v. w5 H8 y4 j. x$ ?

7 D4 z: C! ~% t! a) n2 s9 M9 b3 ^+ ?( m/ x( A

& V1 p; o# O! R4 [+ L$ j关于我们:- a2 z- J) @' G$ t$ p0 \ A- j

深圳逍遥科技有限公司(Latitude Design Automation Inc.)是一家专注于半导体芯片设计自动化(EDA)的高科技软件公司。我们自主开发特色工艺芯片设计和仿真软件,提供成熟的设计解决方案如PIC Studio、MEMS Studio和Meta Studio,分别针对光电芯片、微机电系统、超透镜的设计与仿真。我们提供特色工艺的半导体芯片集成电路版图、IP和PDK工程服务,广泛服务于光通讯、光计算、光量子通信和微纳光子器件领域的头部客户。逍遥科技与国内外晶圆代工厂及硅光/MEMS中试线合作,推动特色工艺半导体产业链发展,致力于为客户提供前沿技术与服务。; Y; t' ]& Y5 i( c) S1 Y

/ y& A/ H9 [) s, q% v

http://www.latitudeda.com/. Y. c0 e! D1 a

(点击上方名片关注我们,发现更多精彩内容) |